Projektbeschreibung des Autors:

"Suchmaschinen sind das populärste Werkzeug des Internets. Mit tausenden von Wörtern wird in jeder Sekunde nach Antworten gesucht. Dieser Wortstrom ist quasi Ausdruck des rohen, ungefilterten kollektiven Begehrens der Menschen im Netz. Einen Einblick in diesen kontinuierlichen Wortstrom gewährt die Suchmaschine Fireball.de mit ihrer Livesuche.

1959 erzeugte zum erstenmal eine Rechenanlage einen literarischen Text. Theo Lutz hatte für die Zuse Z22 ein Programm geschrieben, um stochastische Texte zu erzeugen. Dazu hatte er 16 Subjekte und 16 Prädikate aus Kafkas Das Schloss ausgewählt, die nach bestimmten von ihm festgelegten Regeln zu Sätzen verknüpft wurden.

http://www.stuttgarter-schule.de/lutz_schule.htm

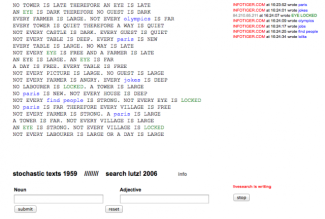

Für die Performance Search Lutz! wird eine Web-Umsetzung von Theo Lutz' Programm, die ich in PHP geschrieben habe, benutzt. Das Webinterface erzeugt, stochastische (zufallsbasierte) Texte auf der Basis von Theo Lutz' Algorithmus.

Gleichzeitig werden die Substantive des benutzten Wortschatzes einerseits kontinuierlich durch Begriffe aus der "Livesuche" ersetzt (d.h. also Wörtern, die gerade von irgendwem in die Suchmaschine Fireball.de eingegeben werden), andererseits werden die verwendeten Substantive und Adjektive über ein Webinterface durch die Besucher der Performance ausgetauscht.

1959 waren die Computertexte zweifach literarisch konnotiert. Einerseits durch den benutzten "Kafka"-Wortschatz, andererseits durch Korrekturen von Theo Lutz. Denn in einem von ihm redigierten Abdruck einer Auswahl der stochastischen Texte hatte Theo Lutz kleine grammatikalische Fehler und fehlende Satzzeichen von Hand korrigiert und somit, entgegen der Programmierung, als "traditioneller" Autor agiert.

Dieses Literarische (oder man könnte auch sagen: dieses "Menscheln") bei diesen ersten computergenerierten Texten soll in der Performance 3-fach aufgegriffen werden, einerseits durch eine literarische Inszenierung der entstehenden Computertexte durch einen professionellen Sprecher. Zweitens durch die Mitautorschaft des Publikums. Als dritte literarische Referenz wird das kollektive Begehren im Netz mitschreiben durch die Hereinnahme von Suchbegriffen, die aktuell mit der Suchmaschine "WEB.DE" gesucht werden. Letzteres ist das rohe und ungefilterte Schreiben im Internet und diese unkontrollierbaren Begriffe und Phrasen aus der Suchmaschine werden ohne jegliche Rechtschreib- oder grammatikalische Anpassung in die Performance eingeschleust. Sie sind somit auch eine Referenz an die grammatikalischen Verstöße von Theo Lutz' Programmierung von 1959.

Was entstehen wird, ist ein höchst komplexes Geflecht der sprachlichen Interaktion zwischen Mensch, Maschine (Programmierung) und Netzkommunikation, zwischen zufälliger Textentstehung, literarischer Absicht, bewusster Manipulation und dem Wortstrom der "Livesuche".

Der generierte Text wird von einem professionellen Sprecher performt."

Author's description:

Nearly 50 years ago a calculator generated a literary text for the first time ever. This happened in Stuttgart, my home town.

In 1959 Theo Lutz wrote a program for Zuse Z22 to create stochastic texts. Following Max Bense’s (a Stuttgardian philosopher) advice, he took sixteen nouns and adjectives out of Kafka’s "Schloss," which the calculator then formed into sentences, following certain patterns. Thus, every sentence began with either "ein" or "jeder" ("one" or "each") or the corresponding negative form "kein" or "nicht jeder" ("no" or "not everybody"). Then the noun, selected arbitrarily from the pool of sixteen given nouns, was linked through the verb "ist" ("is") with the likewise arbitrarily chosen adjective. Last, the whole construction was linked up through "und," "oder," "so gilt" ("and," "either," "thus") or given a full stop. Following these calculation instructions and by means of this algorithm, the machine was able to construct sentences like:

EIN TAG IST TIEF UND JEDES HAUS IST FERN

(A day is deep and every house is distant)

JEDES DORF IST DUNKEL, SO GILT KEIN GAST IST GROSS

(Every village is dark, thus no guest is large)

For the performance of "searchLutz!" I use a web conversion of Theo Lutz’s program which I wrote in PHP. The web interface generates stochastic texts on the basis of Lutz’s algorithm but permits additional word input. The nouns and adjectives of the original vocabulary can be replaced by the audience during the performance by using a terminal. Furthermore words from the live search of the search engine Fireball could infiltrate the text generation process.

In 1959, computer texts were connotated as literary texts in two ways: Firstly through the "Kafka" vocabulary used, and secondly through corrections carried out by Theo Lutz. In a printed copy of a selection of stochastic texts he had edited, Theo Lutz corrected little grammar mistakes and missing punctuation marks by hand, and thus, contrary to programming acted as a "traditional" author. During the performance we refer to these literary features (or one could almost say there is no escaping from one’s humanity) of the first computer-generated texts in two ways: First we do so through the co-authorship of the audience, secondly we have a professional speaker who is reading the so produced computer texts directly off the screen and is thus performing them as they were generated.